So verhindern Sie Gen AI-Halluzinationen in Ihrem Geschäft

Wenn Ihr Unternehmen künstliche Intelligenz (KI) einsetzt – sei es in kleinem oder großem Maßstab –, sind Sie wahrscheinlich bereits auf Fälle gestoßen, in denen sie Fehler macht oder fragwürdige Ergebnisse liefert. Unabhängig davon, ob es sich um traditionelle oder generative KI handelt, besteht immer ein gewisses Risiko für Fehler. Doch bei generativer KI äußert sich dieses Problem in einer besonderen Form: Halluzinationen – also Antworten, die plausibel erscheinen, aber völlig erfunden oder falsch sind. Diese Halluzinationen können nicht nur zu fehlerhaften Geschäftsentscheidungen führen, sondern auch das Vertrauen in KI-Systeme untergraben.

Was genau sind KI-Halluzinationen? Warum entstehen sie? Und vor allem: Wie können Sie verhindern, dass sie auftreten? Hier erfahren Sie alles, was Sie wissen müssen, um KI-Halluzinationen zu verstehen und zu vermeiden.

Was sind generative KI-Halluzinationen?

Bildquelle: macrovector

Halluzinationen der generativen KI (Gen AI) sind falsche, unsinnige oder irreführende Ausgaben, die von Large Language Models (LLMs) erzeugt werden. Diese Modelle ermöglichen es generativen KI-Tools und Chatbots (z. B. ChatGPT), Sprache auf menschenähnliche Weise zu verarbeiten. Obwohl die Antworten oft grammatikalisch korrekt und kohärent erscheinen, fehlt ihnen jegliche Grundlage in der Realität. Sie können sogar völlig am Thema der ursprünglichen Anfrage vorbeigehen.

Mit anderen Worten: Eine Gen-AI-Halluzination liegt vor, wenn das Modell eine Antwort generiert, die faktisch falsch oder nicht relevant für die gestellte Frage ist. Solche Halluzinationen können von kleinen Ungenauigkeiten bis hin zu völlig erfundenen Informationen reichen. Ein Beispiel wäre eine KI, die fälschlicherweise behauptet, das Telefon sei von Thomas Edison erfunden worden, obwohl Alexander Graham Bell der tatsächliche Erfinder war. Oder in der Auftragsabwicklung könnte eine KI Produktnamen oder Preise generieren, die gar nicht existieren.

Der Begriff „Halluzination“ wird zwar normalerweise mit der menschlichen Wahrnehmung in Verbindung gebracht, beschreibt hier aber das Phänomen, dass KI-Modelle Inhalte produzieren, die nicht auf realen Daten basieren. Ähnlich wie Menschen Dinge wahrnehmen können, die nicht existieren, kann generative KI scheinbar plausible, aber faktisch falsche Informationen generieren.

Wie kommt es zu KI-Halluzinationen?

Um zu verstehen, warum KI Halluzinationen erzeugt, ist es wichtig, die grundlegende Funktionsweise von LLMs (Large Language Models) zu kennen. Diese Modelle basieren auf einer sogenannten Transformatorarchitektur, die Texte in Form von Token verarbeitet und das nächste Token in einer Sequenz basierend auf Wahrscheinlichkeiten vorhersagt, die aus den Trainingsdaten abgeleitet wurden. Obwohl LLMs mit riesigen Datenmengen trainiert werden, um Muster und Beziehungen zwischen Token zu erlernen, fehlt ihnen ein echtes Verständnis für den Kontext oder die Bedeutung dieser Daten. Dieses fehlende Kontextverständnis kann dazu führen, dass das Modell scheinbar plausible, aber tatsächlich falsche oder irreführende Antworten generiert.

Neben dem begrenzten Kontextverständnis gibt es weitere Faktoren, die KI-Halluzinationen begünstigen:

- Trainingsverzerrungen: KI-Modelle sind nur so gut wie die Daten, mit denen sie trainiert wurden. Wenn die Trainingsdaten verzerrt oder unausgewogen sind – sei es durch unbeabsichtigte Fehler oder absichtliche Manipulation –, kann das Modell falsche Muster erlernen und ungenaue Vorhersagen treffen.

- Schlechte Schulung: Damit ein KI-Modell zuverlässig funktioniert, benötigt es hochwertige und relevante Trainingsdaten. Sind diese Daten unvollständig, veraltet oder nicht repräsentativ für verschiedene Szenarien, kann das Modell fehlerhafte, irrelevante oder schlicht falsche Antworten liefern.

- Über- und Unteranpassung: Halluzinationen können auch durch eine Über- oder Unteranpassung des Modells entstehen. Bei einer Überanpassung speichert das Modell die Trainingsdaten zu exakt ab, was dazu führt, dass es sich schlecht an neue Eingaben anpasst. Eine Unteranpassung hingegen bedeutet, dass das Modell nicht ausreichend aus den Daten lernt, was zu ungenauen, schwachen oder unsinnigen Antworten führen kann.

Beispiele für Halluzinationen bei Gen-KI

Schauen wir uns einige Beispiele für Halluzinationen in generativer KI an, um zu veranschaulichen, wie diese Fehler Unternehmen schaden können:

- Fehlalarme bei der Auftragsabwicklung

Ein KI-Modell könnte einen Auftrag aufgrund eines falsch interpretierten Schlüsselworts wie „dringend“ als priorisierten Auftrag einstufen, selbst wenn keine beschleunigte Bearbeitung erforderlich ist. Dies kann dazu führen, dass unnötig Ressourcen zugewiesen werden, die Betriebskosten steigen und tatsächlich dringende Bestellungen verzögert werden. - Falsche Vorhersagen im Vertrieb

Ein KI-Modell zur Vorhersage von Verkaufsaufträgen könnte aufgrund vergangener saisonaler Trends einen Anstieg der Kundennachfrage prognostizieren. Wenn sich jedoch die Marktbedingungen geändert haben – etwa durch veränderte Verbraucherpräferenzen oder eine wirtschaftliche Abschwächung –, könnte die fehlerhafte Vorhersage zu Überproduktion oder Überbeständen führen, was finanzielle Verluste für das Unternehmen nach sich zieht.

Wie man KI-Halluzinationen verhindert

Bildquelle: Freepik

Jetzt, da wir ein besseres Verständnis davon haben, was KI-Halluzinationen sind und warum sie auftreten, bleibt die wichtigste Frage: Wie lassen sie sich vermeiden? Hier sind einige bewährte Methoden, um das Risiko von KI-Halluzinationen zu minimieren:

Spezifische und relevante Trainingsdaten verwenden

Generative KI-Modelle sind auf qualitativ hochwertige Eingabedaten angewiesen. Um Halluzinationen zu vermeiden, sollten die verwendeten Trainingsdaten relevant, vielfältig und strukturiert sein. Daten mit Verzerrungen oder unvollständige Informationen können dazu führen, dass das Modell falsche Muster erlernt. Durch eine gezielte Auswahl und regelmäßige Aktualisierung der Daten verbessern Sie nicht nur die Genauigkeit der KI, sondern reduzieren auch das Risiko irreführender Ausgaben.

Klare Modellziele definieren

Welche Aufgaben soll das KI-Modell erfüllen? Um Halluzinationen zu minimieren, ist es entscheidend, klare Ziele für das Modell festzulegen. Dazu gehört die Definition der spezifischen Aufgaben, für die es eingesetzt wird, sowie aller relevanten Einschränkungen oder Rahmenbedingungen. Indem Sie diese Parameter im Voraus bestimmen, stellen Sie sicher, dass die KI gezielt arbeitet und die Wahrscheinlichkeit fehlerhafter Ergebnisse verringert wird.

Eine Vorlage für die KI erstellen

Beim Training eines Gen-AI-Modells ist es entscheidend, ihm eine klare Struktur oder eine Reihe von Richtlinien bereitzustellen. Diese Vorlage dient als Orientierungshilfe und unterstützt das Modell dabei, präzisere Vorhersagen zu treffen. Wenn Sie beispielsweise ein KI-Modell für die Erstellung von Produktbeschreibungen trainieren, können Sie eine Vorlage definieren, die wesentliche Elemente wie Merkmale, Vorteile und Spezifikationen enthält. Durch diese strukturierte Vorgabe kann die KI konsistentere und relevantere Inhalte generieren, wodurch das Risiko von Halluzinationen reduziert wird.

Menschliche Aufsicht einbinden

Menschliche Aufsicht ist entscheidend, um KI-Halluzinationen zu minimieren. Generative KI ist zwar ein leistungsfähiges Werkzeug, aber nicht fehlerfrei. Die Einbindung menschlicher Kontrolle bei der Überprüfung und Validierung der KI-Ausgaben dient als zusätzliche Sicherheitsmaßnahme, um Fehler frühzeitig zu erkennen und problematische Ergebnisse zu verhindern. Zudem kann ein menschlicher Prüfer wertvollen Kontext und Fachwissen beisteuern, das der KI fehlt. Dies ermöglicht eine fundierte Bewertung der Genauigkeit, Relevanz und Angemessenheit der generierten Inhalte. Durch die Kombination von KI und menschlicher Aufsicht lassen sich Halluzinationen reduzieren und die Gesamtqualität der KI-Ergebnisse nachhaltig verbessern.

Retrieval-Augmented Generation (RGA) nutzen

Eine effektive Methode zur Vermeidung von KI-Halluzinationen ist die Retrieval-Augmented Generation (RAG). Diese Technik verbessert generative KI-Modelle, indem sie Echtzeit-Wissensquellen in den Antwortprozess integriert. Das Kernproblem großer Sprachmodelle (LLMs) besteht darin, dass sie keine Fakten "verstehen", sondern Text basierend auf statistischen Mustern generieren. Dadurch entstehen kohärente, aber potenziell falsche oder irreführende Antworten – sogenannte Halluzinationen.

RAG behebt dieses Problem, indem es LLMs erlaubt, externe, verifizierte Daten durch gezielte Abfragen abzurufen, bevor eine Antwort generiert wird. Anstatt sich ausschließlich auf veraltetes oder begrenztes Trainingswissen zu stützen, greift die KI auf strukturierte Echtzeitdaten aus zuverlässigen Quellen wie Datenbanken, Branchenberichten oder firmeneigenen Dokumenten zu.

Dieser Retrieval-Prozess minimiert Halluzinationen erheblich, da die KI nun mit überprüften, aktuellen Informationen arbeitet. Gleichzeitig erhöht sich die Transparenz, da Unternehmen genau nachvollziehen können, auf welche Quellen sich die KI stützt. Mit RAG können Unternehmen sicherstellen, dass ihre KI-Systeme nicht nur sprachlich überzeugend, sondern auch inhaltlich korrekt sind. Dies führt zu fundierteren Geschäftsentscheidungen, höherer Effizienz und einem geringeren Risiko fehlerhafter oder irreführender Antworten.

Was Sie erwartet

Im Gegensatz zu herkömmlichen KI-Modellen, die strikten Regeln und Anweisungen folgen, generieren Gen-KI-Modelle kreative und unkonventionelle Ergebnisse. Diese Fähigkeit kann zu bahnbrechenden Innovationen führen, birgt jedoch auch das Risiko von Halluzinationen. Solche Fehler treten besonders dann auf, wenn die KI mit mehrdeutigen oder unvollständigen Daten konfrontiert wird. Während Halluzinationen vermutlich nicht vollständig verschwinden, wird sich ihre Natur weiterentwickeln, da Unternehmen zunehmend ausgefeiltere Methoden zu ihrer Eindämmung entwickeln.

Mit der Weiterentwicklung von Gen-KI-Modellen werden diese besser darin, sprachliche Nuancen zu erkennen, Benutzerabsichten und Kontexte zu verstehen sowie präzisere Vorhersagen zu treffen. Zudem werden sie verschiedene Datentypen – wie Text, Bilder und Audio – intelligenter verarbeiten und analysieren können. Diese Fortschritte könnten dazu beitragen, KI-Halluzinationen in Zukunft erheblich zu reduzieren oder sogar zu eliminieren.

Auch wenn das Risiko nie vollständig ausgeschlossen werden kann, können Unternehmen durch proaktive Maßnahmen gezielt entgegenwirken. Der Einsatz hochwertiger Trainingsdaten, die klare Definition von Zielen, die Bereitstellung strukturierter Vorlagen und die Integration menschlicher Aufsicht helfen dabei, dass Gen-KI-Modelle präzise und verlässliche Ergebnisse liefern, die den geschäftlichen Anforderungen entsprechen.

{{de-cta-block-blog}}

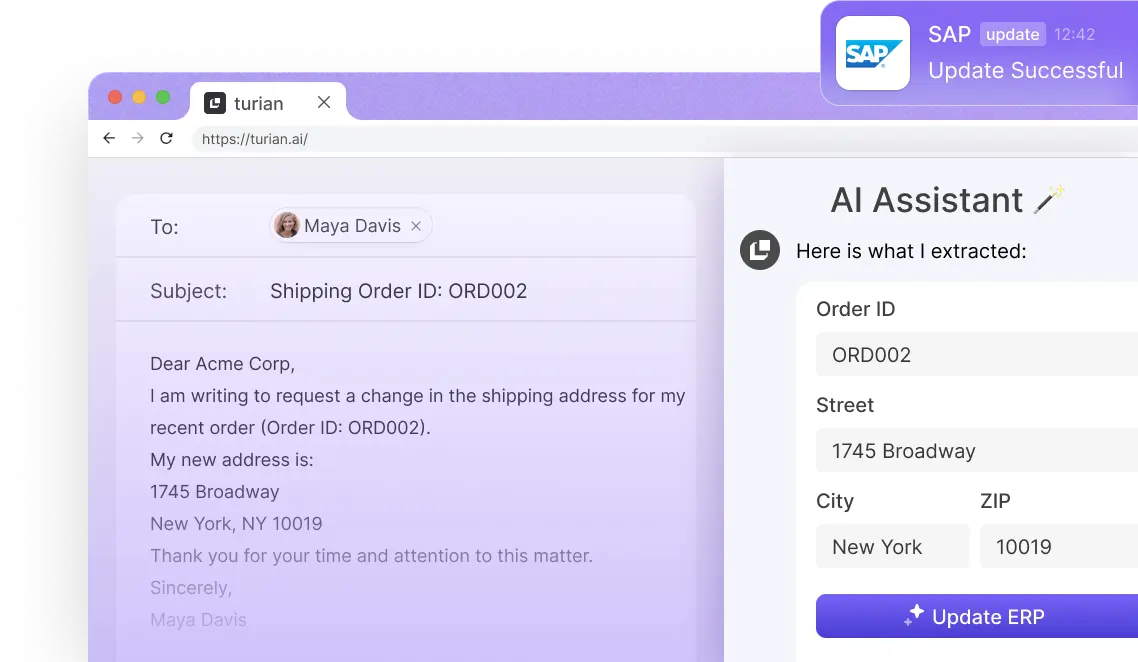

Say hi to your

AI Assistant!

Lernen Sie Ihren KI-Assistenten kennen!

.avif)

FAQ

Die kurze Antwort lautet: Ja. Selbst gut trainierte KI-Modelle können Halluzinationen erzeugen, also ungenaue oder irreführende Ergebnisse liefern. Obwohl diese Modelle mit riesigen Datenmengen trainiert werden, sind sie nicht fehlerfrei. Halluzinationen können aus verschiedenen Gründen auftreten, etwa durch unzureichende oder verzerrte Trainingsdaten, unklar definierte Eingabeaufforderungen oder die grundlegenden Einschränkungen von KI-Modellen bei der Verarbeitung und Interpretation von Informationen. Da KI-Modelle auf statistische Muster und Wahrscheinlichkeiten setzen, anstatt den Kontext oder die Bedeutung hinter den Daten wirklich zu verstehen, besteht selbst bei ausgereiften Systemen immer die Möglichkeit, fehlerhafte oder unsinnige Ergebnisse zu generieren.

Menschliche Aufsicht spielt eine zentrale Rolle bei der Reduzierung von Halluzinationen in KI-Modellen. Indem Menschen in den Überprüfungs- und Validierungsprozess eingebunden werden, lassen sich Fehler frühzeitig erkennen und korrigieren, bevor sie zu größeren Problemen führen. Ein menschlicher Prüfer kann zudem Kontext und Fachwissen einbringen, das der KI fehlt, und beurteilen, ob die generierten Inhalte korrekt, relevant und für die jeweilige Aufgabe angemessen sind. Darüber hinaus trägt die menschliche Aufsicht dazu bei, Verzerrungen im Modell zu identifizieren und sicherzustellen, dass die Ergebnisse fair und unvoreingenommen bleiben. Durch diese zusätzliche Kontrolle wird die Zuverlässigkeit und Genauigkeit von KI-Modellen verbessert.

Bei turian wissen wir, dass Halluzinationen für Unternehmen, die KI-Modelle einsetzen, ein ernsthaftes Problem darstellen können. Deshalb haben wir mehrere Mechanismen implementiert, um sicherzustellen, dass unsere KI-Lösungen keine falschen oder erfundenen Informationen generieren. Unsere Lösungen nutzen die RAG-Technologie (Retrieval-Augmented Generation), die abrufbasierte und generative Methoden kombiniert, um genauere, kontextbezogene Antworten zu liefern. Zudem setzen wir maßgeschneiderte Geschäftsregeln und Algorithmen ein, die die Qualität und Plausibilität der generierten Inhalte sicherstellen. So helfen wir Unternehmen, verlässliche KI-Ergebnisse zu erzielen und fundierte, datengestützte Entscheidungen zu treffen.

Das Risiko von KI-Halluzinationen lässt sich nicht vollständig eliminieren, aber Unternehmen können gezielte Maßnahmen ergreifen, um ihre Auswirkungen zu minimieren. Die Verwendung hochwertiger Trainingsdaten, die Festlegung klarer Modellziele, die Bereitstellung von Vorlagen und die Einbindung menschlicher Aufsicht tragen dazu bei, dass KI-Modelle präzisere und relevantere Ergebnisse liefern. Zudem kann die Sicherstellung, dass KI-Modelle auf der Grundlage vielfältiger und glaubwürdiger Datenquellen trainiert werden, das Risiko ungenauer Inhalte reduzieren. Durch die kontinuierliche Überwachung der generierten Ergebnisse auf Konsistenz und Relevanz können Unternehmen sicherstellen, dass ihre KI-Systeme zuverlässige und fundierte Antworten liefern.